4.2 Bias, Ethik und Diskriminierung in KI-Modellen

Bias in Trainingsdaten

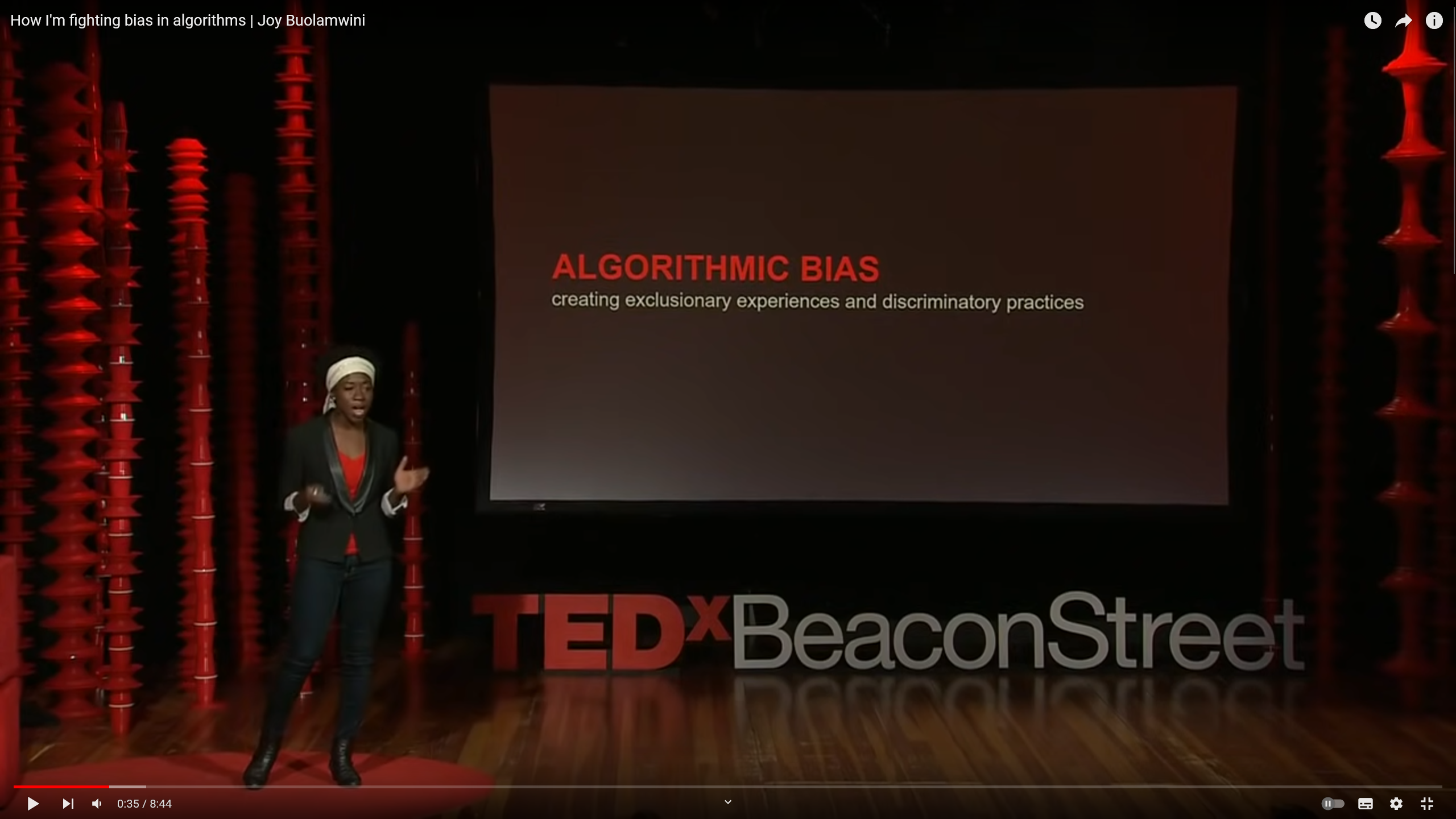

Das KI-Systeme durch Trainingsdaten lernen, welche die Basis für spätere Entscheidungen und Aktionen darstellen, weißt du bereits. Verzerren diese Daten die Realität oder beinhalten Vorurteile, kann das zu diskriminierenden Ausgaben führen. Beispielsweise können Bewerbungsauswahl-Tools, die auf historischen Einstellungsdaten trainiert wurden, die bestehenden Geschlechts- oder ethnischen Bias verstärken. Oder die KI-gestützte Gesichtserkennungssoftware erkennt dein Gesicht nicht, weil du eine BIPoC bist und das KI-Modell von weißen Menschen trainiert wurde - so geschehen bei Joy Buolamwini, die ihre Geschichte im folgenden Ted-Talk erzählt. Es ist daher entscheidend, dass Datensätze umfassend hinsichtlich ihrer Repräsentativität und Objektivität geprüft werden.

Quelle: https://www.youtube-nocookie.com/embed/UG_X_7g63rY?si=D8FV5ZqasIMkBsl

Quelle: https://www.youtube-nocookie.com/embed/UG_X_7g63rY?si=D8FV5ZqasIMkBsl

Ethik in KI-Prompting

Wie du sicher festgestellt hast, hängen Fehler, Ethik und Diskriminierung eng zusammen. Die Gewährleistung ethischer Grundsätze in KI-Systemen, wie Fairness, Gerechtigkeit und Nicht-Diskriminierung, ist von zentraler Bedeutung, um zu verhindern, dass KI ein Treiber der gesellschaftlichen Spaltung wird (oder bleibt?). Hierbei spielen ethische Richtlinien für die Entwicklung und den Einsatz von KI eine Rolle, ebenso wie die Ausbildung von KI-Entwickler*innen und in Ethik. Die vorhin angesprochene Timnit Gebru war nach ihrer Kündigung bei Google zu Gast im TWIML (This week in Machine Learning) Podcast und gibt einen Einblick wie Fairness und Ethik Einzug in die Entwicklung von KI halten könnte. Hier ist der Link.

Smart-Action: Ethik in der KI-Entwicklung 🤖

Quellen und Ressourcen

Wenn ihr Lust auf einen Deep Dive zum Thema habt, dann immer hier entlang: Link.

In diesem Artikel wird erläutert, wie KI-Ethik messbar gemacht werden kann.